AnxinFS存储系统

AnxinFS存储系统是一款企业级分布式文件系统和集群NAS。为用户提供容量和性能横向扩展的高可靠、高性能文件存储服务。基于AnxinFS,用户业务系统在文件存储方面的性能和扩展瓶颈可以得到有效解决。 .

AnxinFS存储技术特点

- 端到端RDMA技术:AnxinFS分布式支持NFS RDMA和SMB Direct,利用RDMA技术,可以有效的降低客户端CPU利用率,降低访问时延。

- 自研链路聚合技术:AnxinFS自己维护各链路的状态、实现高冗余/容错。不仅为用户节约交换成本,比常规的Bonding效率更高,还减轻系统管理员和运维人员的工作量。

- 自研NAS服务组件:自研核心模块发挥现代CPU多核优势,性能提升50% ~100% (具体取决于业务程序的IO模式)

- 元数据/数据分离存储,优化文件访问性能:通过自研的核心驱动和数据保护机制(元数据多副本,数据为EC),不仅充分发挥了多盘聚合性能,还能确保部分硬盘失效的前提下数据不丢失、访问不中断。

- 内存拷贝优化:AnxinFS各组件针对内存的使用进行了深入优化,各个模块之间的数据共享实现了零拷贝。这不仅缩短了网络包和文件I/O处理路径上的延迟;还通过自研的缓存管理模块隔离了Linux操作系统VM的影响,使得各种情况下AnxinFS的性能曲线相对平稳。

- PBRA 智能预读技术:自建缓存管理 ,预读优化,多磁盘协同 。智能预读技术可以有效提高读数据的响应速度及带宽,消除了带宽抖动对时延敏感型应用非常友好。

- PBAllocsize灵活的空间分配策略:Allocsize大小按需设置,系统根据目录、文件名或者存储文件类型自动按需匹配相应Allocsize,大文件存放连续性更好,小文件不浪费空间。

- 一键在线扩容:扩容过程轻松简单,无需对新节点做任何基础配置,接好线缆开机,一键扩容。

- 数据再均衡:当新增节点后,AnxinFS需启动数据再均衡,无缝数据迁移,实现集群内数据最优化的分布和均衡。数据迁移和重新均衡的过程不会影响应用对数据的访问。

- GDS:GDS技术使得GPU可以直接访问存储中的数据,这种以直接内存的存取方式,从而实现 CPU 和系统内存的 IO 旁路,吞吐能力不再受限于系统总线的带宽压力。同时 IO 过程中避免了数据通路中多次内存拷贝所带来的额外时延开销,使得GPU到存储之间的访问获得更大的带宽和更低的时延。

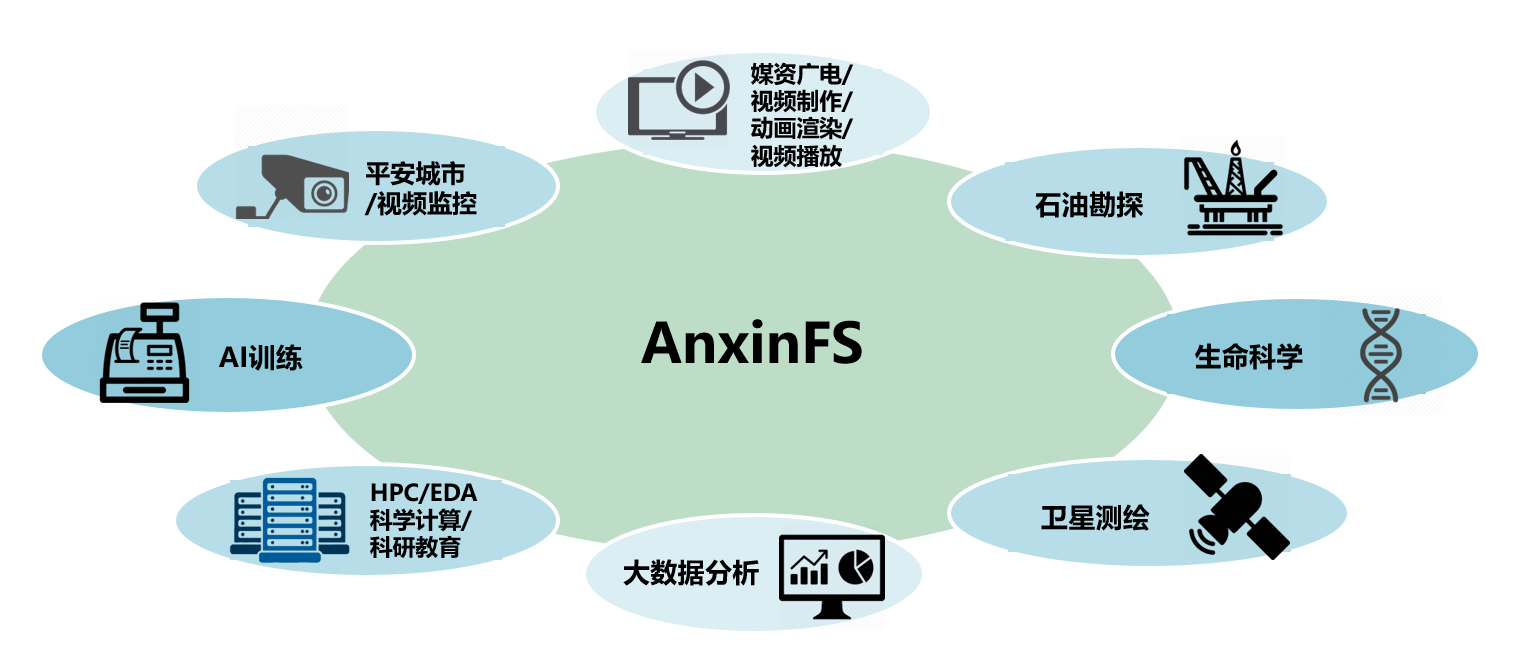

应用场景